Nota Técnica

|

|

| Aplicativo GAMMA-GUI: uma interface gráfica amigável para análise exploratória de dados no MATLAB GAMMA-GUI APP: a user-friendly graphical interface for exploratory data analysis in MATLAB |

|

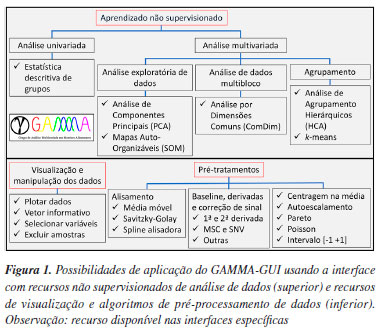

Diego GalvanI,*,# I. Departamento de Química, Universidade Federal de Santa Catarina (UFSC), 88040-900 Florianópolis - SC, Brasil Recebido: 19/05/2025 *e-mail: diego.galvan@ufsc.br; ebona@utfpr.edu.br In this work, we continue our series of tutorial articles published in the Química Nova exploring different features of the GAMMA-GUI app (Grupo de Análise Multivariada em Matrizes Alimentares), a user-friendly interface for the multivariate analysis in Matlab®. This time, we demonstrate five types of exploratory data analysis (unsupervised learning), complemented by video demonstrations on our YouTube channel. Applications consist of demonstration with: (i) principal component analysis (PCA); (ii) self-organizing maps (SOM); (iii) hierarchical cluster analysis (HCA); (iv) k-means, and (v) common dimensions analysis (ComDim). Additionally, a demonstration of descriptive statistics with Tukey HSD (honest significant difference) has been included in this tutorial. Suggestions for improvements or new ideas for the app are welcome and can be directed to the developers. INTRODUÇÃO A quimiometria é a ciência que relaciona medidas feitas em um sistema ou processo químico, utilizando métodos matemáticos e estatísticos.1 As principais categorias da quimiometria incluem técnicas de planejamento de experimentos e de análise exploratória de dados, classificação e calibração multivariadas.2 Essas subdivisões representam abordagens distintas para lidar com experimentos e conjuntos de dados complexos de origem química, sendo fundamentais para a extração de características, classificações e calibrações em contextos multivariados. Outra subdivisão relevante no campo do aprendizado de máquina (machine learning) diz respeito à forma como os algoritmos processam os dados, os aprendizados supervisionados (supervised learning) e não supervisionados (unsupervised learning).3,4 Os não supervisionados não requerem conhecimento prévio sobre as saídas dos dados durante a fase de aprendizagem, ou seja, os dados não são rotulados, não possuem saídas pré-definidas nem variáveis-alvo. Já os supervisionados exigem a disponibilidade prévia (a priori) de informações qualitativa (para classificação) ou quantitativa (para calibração) para a construção dos modelos. Isso significa que os dados de treinamento são rotulados, com uma saída pré-definida ou variáveis-alvo. Em um problema de reconhecimento de padrões supervisionado, os preditores qualitativos ou quantitativos podem ser "aprendidos" de modo direcionado à resposta de interesse, enquanto em um problema não supervisionado os comportamentos são "aprendidos" de acordo com a similaridade das amostras disponíveis.4 O aprendizado não supervisionado é amplamente utilizado para fins exploratórios, para identificar tendências, semelhanças e diferenças entre amostras, reduzir a dimensionalidade dos dados e/ou extraindo padrões dominantes em matrizes de dados complexas, podendo ainda ser dividido entre análise exploratória de dados (exploratory data analysis, EDA) e agrupamento (clustering).5,6 A principal distinção reside no fato que, nos EDA, a ênfase recai sobre a compreensão intrínseca dos dados, destacando-se pela sua capacidade de revelar padrões sem a necessidade de formar grupos predefinidos, enquanto as técnicas de agrupamentos têm como finalidade agrupar as amostras com base em critérios específicos. Para o tratamento de dados de natureza química, destacam-se, devido a simplicidade, eficácia e robustez que proporcionam, a análise de componentes principais (principal component analysis, PCA), os mapas auto-organizáveis (self-organizing maps, SOM), a análise por agrupamento hierárquicos (hierarchical cluster analysis, HCA), o k-médias (k-means) e a análise por dimensões comuns (common dimensionanalysis, ComDim). Embora não exista uma distinção clara entre quimiometria e aprendizado de máquina, adotaremos a definição proposta por Santos et al.7 A quimiometria refere-se a abordagens baseadas em projeções, como a análise de componentes principais e fatorial, enquanto o aprendizado de máquina abrange um conjunto de algoritmos avançados que aprendem com os dados, direcionados à modelagem não linear e de alta complexidade. Essa distinção também reflete nas ferramentas utilizadas. Na emergente área de Ciência de Dados, cientistas de dados tendem a adotar linguagens como Python e uso de aprendizado de máquina. Por outro lado, quimiometristas ou cientistas de dados químicos, tradicionalmente vinculados à já consolidada Comunidade de Quimiometria, utilizam predominantemente o Matlab (MathWorks), como pode ser comprovado por meio de várias interfaces gráficas disponíveis gratuitamente como "MVC1",8 "MVC2",9 "MVC3",10 "DD-SIMCA",11 "PLS-DA",12 "MCR-ALS_GUI",13 etc., e comercialmente o "PLS_Toolbox". Alguns aplicativos em português já foram desenvolvidos para análise multivariada de dados, como o "ChemoStat",14 o "REDGIM®"15 e o "Photometrix".16 Embora sejam aplicativos bastante úteis, eles possuem algumas limitações, estando restritos somente à PCA, HCA e PLS (partial least squares). Além disso, o REDGIM® e o Photometrix foram especificamente projetados para a análise de imagens digitais, o que pode limitar sua aplicação para outros tipos de dados. No aplicativo GAMMA-GUI (Grupo de Análise Multivariada em Matrizes Alimentares), há uma série de interfaces e algoritmos direcionadas a técnicas de planejamento de experimentos e de análise exploratória de dados, classificação e calibração multivariadas, todos reunidos em uma única plataforma. Além disso, o GAMMA-GUI foi desenvolvido para ser flexível e não restrito a um único tipo de dado, ampliando suas possibilidades de aplicação. Em nosso primeiro tutorial com o aplicativo GAMMA-GUI, publicado na Química Nova,17 abordamos as técnicas de planejamento de experimentos (design of experiments, DoE). O GAMMA-GUI consiste em uma interface gráfica e amigável, desenvolvida em GUI (graphical user interface, GUI) e implementado usando programação orientada a objetos (object-oriented programming, OOP) do software Matlab®. O aplicativo permite que usuários novatos e experientes realizem tarefas de forma eficaz e eficiente, embora ainda seja necessário que os usuários tenham conhecimentos prévios de quimiometria. Além disso, a interface do aplicativo encontra-se em português-BR, conta com vídeos tutoriais demonstrativos no YouTube®18 e pode ser baixada gratuitamente no File Exchange - MATLAB Central19 ou no GitHub®.20 Dando continuidade à nossa série de artigos tutoriais, neste guia exploraremos a interface dedicada ao aprendizado não supervisionado, utilizando dados reais da literatura.

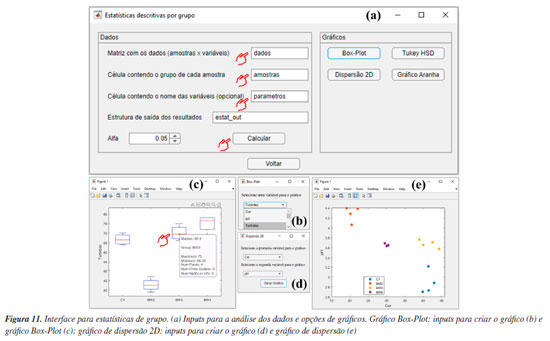

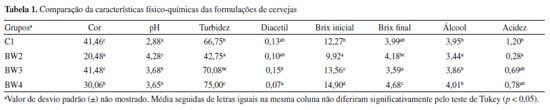

RECURSOS INTEGRADOS NA INTERFACE DE ANÁLISE EXPLORATÓRIA Os recursos de análise integrados na interface "Análise exploratória" do aplicativo GAMMA-GUI podem ser visualizados na Figura 1. Nesta interface, os usuários têm acesso à PCA, SOM, ComDim, HCA e k-means, além de funcionalidades para análise estatística descritiva de grupos. Adicionalmente, os usuários contam com recursos de visualização e pré-tratamentos de dados na interface "Visualização e pré-tratamentos".

Antes de iniciarmos, faremos um resumo da nomenclatura adotada neste tutorial. É fundamental esclarecer a nomenclatura usual referente à "técnica analítica", "método analítico", "modelo" e "algoritmo". As definições adotadas seguem, em grande parte, aquelas sugeridas por Mazivila e Olivieri.21 "Técnica analítica" refere-se a um procedimento instrumental utilizado para determinar a concentração de um analito. "Método analítico" é a aplicação específica de uma técnica a uma determinada amostra, sob condições definidas de medição. "Modelo" consiste em uma representação matemática que descreve as propriedades dos dados. "Algoritmo" é um conjunto detalhado de instruções destinado à execução de uma tarefa computacional. Como exemplo técnico, a PCA é um modelo quimiométrico, enquanto o SOM é um modelo de aprendizagem. Os filtros SNV (standard normal variate) e MSC (multiplicative scatter correction) são algoritmos utilizados para o pré-processamento de dados. A espectroscopia no infravermelho próximo (NIR) é uma técnica analítica. Já o método analítico pode ser entendido como a combinação de uma técnica analítica, como a espectroscopia NIR, com uma abordagem baseada em dados, como um modelo quimiométrico ou de aprendizagem. Além disso, são apresentados alguns conceitos fundamentais de álgebra linear e análise de dados essenciais para iniciantes. Entretanto, esse texto é apenas um breve guia para os usuários, discussões mais aprofundadas e sistemáticas podem ser encontradas nas obras específicas.1,3,6,22

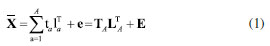

A seguir, fornecemos uma breve fundamentação teórica dedicada aos recursos de aprendizagem não supervisionada mais utilizados na química que podem ser encontrados no aplicativo GAMMA-GUI. Análise de componentes principais (PCA) A PCA é um modelo quimiométrico baseado em projeção, amplamente utilizado para a redução da dimensionalidade de dados multivariados. Considerada a principal técnica de EDA, a PCA realiza uma transformação da base do espaço das variáveis originais, de dimensão RJ, para um novo espaço RA formado pelas A componentes principais utilizadas (PC). Essas componentes, também conhecidas como fatores, são definidas pelos autovetores da matriz de covariância/correlação que fornecem as direções das componentes principais no espaço RA e são determinadas de forma a maximizar a variância extraída dos dados. Cada PC possui um autovalor, que representa a quantidade de variância explicada por essa componente. As PCs são ordenadas em ordem decrescente de variância explicada, conforme indicado por seus autovalores. Ou seja, a primeira componente retém a maior parte da variabilidade dos dados, seguida pelas demais em ordem de importância, sendo que os autovalores diminuem progressivamente. Essa transformação de um conjunto original de variáveis inicialmente correlacionadas entre si, para um conjunto de variáveis não correlacionáveis entre si, é chamado de "compressão" devido a redução da dimensionalidade do conjunto de dados.1,3,6,22 O ponto de partida da PCA consiste na definição da matriz de dados X, que é constituída por I linhas (amostras) e J colunas (variáveis).

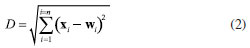

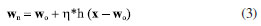

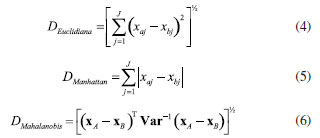

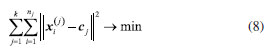

A decomposição dessa matriz  A matriz de escores T contêm as coordenadas de cada amostra em relação aos eixos das PCs, enquanto a matriz de pesos L contém a informação de quanto cada variável original contribuiu na formação de cada PC.3 O processo de decomposição da matriz pode ser realizado de diferentes formas, sendo a decomposição por valores singulares (singular value decomposition, SVD) a mais frequente devido à sua melhor performance para grandes conjuntos de dados com muitas variáveis. Entretanto, outra abordagem comum para calcular as matrizes de escores e de pesos é através do algoritmo NIPALS (nonlinear iterative partial least squares). Mais detalhes a respeito da decomposição SVD e NIPALS é dada por Ferreira.3 Uma descrição mais abrangente e clássica da PCA é apresentada por Bro e Smilde,25 enquanto Rodionova et al.26 discutem as novas ferramentas e tendências recentemente associadas ao modelo PCA. Mapas auto-organizáveis (SOM) O SOM é modelo de aprendizagem não linear para análise exploratória de dados complementar à PCA, introduzido por Teuvo Kohonen na década de 1980.27 Quando o uso de modelos quimiométricos lineares, como a PCA, não for muito informativo devido a uma estrutura de dados complexa, abordagens não lineares podem permitir uma melhor compreensão dos dados.1 Como o nome sugere, no SOM os dados são organizados de modo não supervisionado em um "mapa" tipicamente bidimensional, semelhante, ao gráfico de escores da PCA. O SOM é considerado uma rede neural competitiva do tipo feed-forward de camada única, inspirada no cérebro humano, e seu fundamento consiste em nós de entrada e uma grade de nós computacionais conectados (neurônios) que competem entre si para serem "ativados". Durante o treinamento da rede neural, o neurônio i com a menor distância Euclidiana D (Equação 2) entre o vetor de entrada x e o vetor de pesos do neurônio w é chamado de "neurônio vencedor" ou best matching unit (BMU).1,6,27,28  Durante a etapa de cooperação os vetores modelos nas proximidades do BMU vão cooperar para formar uma região do SOM especializada em padrões similares ao da amostra x. Em seguida, ocorre o processo de atualização dos pesos dos neurônios vizinhos ao BMU seguindo o postulado de aprendizagem de Hebb (Equação 3).  Sendo que wn representa o novo vetor de pesos do neurônio, wo o vetor de pesos do neurônio antes da atualização, η a taxa de aprendizado e h a função de vizinhança. O processo é repetido várias vezes até que os neurônios estejam organizados em um mapa topológico, onde neurônios próximos representam dados similares.1,6,27,28 Análise de agrupamentos hierárquicos (HCA) A HCA é um modelo quimiométrico não supervisionado de agrupamento "suave" (soft clustering), pois os objetos podem pertencer a múltiplos clusters em diferentes níveis de hierarquia, útil para redução da dimensionalidade de grandes conjuntos de dados. Inicialmente, ocorre um particionamento dos objetos em k = 1,..., n clusters, que posteriormente são ordenadas hierarquicamente pelo modo aglomerativo ou divisivo. A opção aglomerativa é a adotada no aplicativo, por meio da função "linkage" do Matlab.29 Nessa abordagem, o primeiro passo consiste em considerar cada objeto como um grupo unitário/único, e então, segue agrupando sistematicamente os grupos por ordem de similaridade. No caso da abordagem divisiva, inicia-se por grupos que vão se dividindo em subgrupos por dissimilaridade.3 Os clusters são formados entre amostras que tenham comportamento semelhante, cuja fundamentação consiste em maximizar a homogeneidade intragrupo e maximizar a heterogeneidade intergrupo. Uma maneira de determinar semelhanças entre as amostras, é feito através do conceito de métricas de distância entres eles, que podem ser obtidas de diferentes formas.1,3 No espaço multivariado RJ, a distância estimada entre dois objetos definidos pelos vetores xA (com componentes/variáveis xA1, xA2,..., xAj) e xB (com componentes/variáveis xB1, xB2,..., xBj) mais populares entre os químicos é a Euclidiana, Manhattan (cityblock) e Mahalanobis (Equações 4, 5 e 6), onde Var-1, é a inversa de matriz de variância-covariância que explica a dispersão dos dados ao redor do centroide. Para mais detalhes consultar Ferreira.3,30  Existem ainda outras métricas de distância, entre elas, destacam-se a distância Euclidiana ao quadrado, Minkowski, Chebyshev, cosseno (cosine), correlação (correlation), Spearman, Hamming e Jaccard. Maiores detalhes sobre essas estimativas podem ser encontrados em Varmuza e Filzmoser 1 e ajuda do Matlab.31 A etapa seguinte consiste no "linkage", que calcula a distância entre os grupos de amostras durante a construção do dendrograma, que são obtidos utilizando índices de similaridade, que permitem identificar grupos de objetos com base em diferentes níveis de similaridade, onde o comprimento dos ramos reflete diretamente o grau de similaridade entre os grupos. Então, a distância entre dois clusters com índice l e m pode ser determinada de várias maneiras, sendo os mais utilizados o algoritmo do vizinho mais próximo (single), mais distante (complete), pela média (average), centroide e de Ward.1,3 Entretanto, outros algoritmos para calcular distância entre clusters pela mediana (median) e distância média ponderada (weighted) também podem ser utilizadas.29 O single forma agrupamentos esparsos, usando a menor distância entre elementos, sendo robusto a outliers. O complete, é baseado na maior distância, e produz clusters compactos, mas é sensível a outliers. O average equilibra ambos, calculando a média das distâncias, enquanto o weighted faz o mesmo, mas atribui pesos iguais aos clusters, independentemente do tamanho. O median usa a mediana das distâncias, sendo mais robusto que o centróide. Já o método do centróide agrupa clusters pela proximidade de seus centróides, mas pode gerar intercruzamentos no dendrograma. Por fim, o Ward minimiza a variância interna, criando grupos homogêneos e balanceados, porém com maior custo computacional. Todos, os "linkage" exceto single e complete, são interpretáveis via centróides ou médias.1,3,29 Agrupamento k-means O k-means é considerado um modelo de aprendizagem não supervisionado de agrupamento "rígido" (hard clustering), ou seja, cada ponto de dados no espaço n-dimensional pertence apenas a um cluster. As estimativas das distâncias entre pares de objetos, juntamente com a definição do número desejado de k-clusters, formam a base fundamental do k-means. Internamente, o algoritmo utiliza os chamados centroides (means), que representam o centro de cada cluster.1,28,32 Um centroide cj de um cluster j = 1,..., k, pode ser definido como o vetor da média aritmética de todos os objetos do cluster correspondente (Equação 7).  O k-means tem como objetivo minimizar a soma dos quadrados total dentro do cluster(Equação 8).  onde Análise por dimensões comuns (ComDim) O ComDim pertence à classe de análise de dados multibloco, cujo objetivo é extrair uma representação global de um conjunto comum de amostras, a partir de diferentes matrizes que contêm informações de naturezas distintas. A decomposição é descrita pela Equação 9.  onde Wk = XkXkT é a matriz de produtos cruzados associada à matriz de dados Xk, sendo k = 1, 2,...K, resultando em uma matriz quadrada de dimensão I × I, onde I é o número de amostras. Cada matriz Xk é inicialmente normalizada por sua norma de Frobenius, dada por As CDs são extraídas sequencialmente, empregando um algoritmo similar ao NIPALS, a partir da matriz WG (concatenação ponderada pela respectiva saliência de cada matriz Wk). As saliências são inicializadas com valores unitários e recalculadas em cada iteração do algoritmo até atingir o critério de convergência. Após a extração da primeira CD as matrizes individuais são deflacionadas e o processo é repetido para a extração das próximas CDs. A matriz WG pode ser decomposta de maneira não supervisionada de três distintas formas, empregando a decomposição em valores singulares (SVD), por análise de componentes independentes (independent components analysis, ICA) ou por análise de componentes comuns (common components analysis, CCA). Para mais detalhes consultar os trabalhos de Bouveresse e Rutledge,35 Mishra et al.,36 Cariou et al.37 e El Ghaziri et al.38 A cada CD extraída é obtido um conjunto de saliências, escores e pesos. A saliência representa o peso atribuído a cada bloco para a construção de uma dada CD, e pode ser interpretada como a variância do bloco representada naquela CD, os escores representam as projeções das amostras no espaço comum da CD, e os loadings os pesos das variáveis contidas em cada bloco, análoga a PCA.34,39 Um fator essencial a ser considerado antes da análise do ComDim, é que os conjuntos de dados ou blocos gerados com diferentes técnicas analíticas (como espectroscópicos, cromatográficos, eletroanalíticos, entre outros) devem ser provenientes das mesmas I amostras. Em outras palavras, as matrizes podem ter diferentes tamanhos para as J colunas (variáveis), mas precisam ter o mesmo número de I linhas (amostras). Além disso, é fundamental observar que as amostras devem estar organizadas na mesma ordem em cada matriz Xk antes da análise dos dados.34 Estatística descritiva univariada Frequentemente, nos deparamos com a necessidade de realizar comparações entre duas ou mais médias populacionais. Nestes casos a realização de múltiplos testes t não é apropriada para avaliar a significância das diferenças entre as médias de pares de grupos, pois a probabilidade de um erro Tipo I aumenta com o número de comparações entre grupos. Portanto, testes para múltiplas comparações de grupos, como a análise de variância (analysis of variance, ANOVA), são mais apropriados, desde que o conjunto de dados atenda aos critérios, como distribuição normal dos resíduos e homogeneidade de variância, que podem ser verificadas pelos testes de Shapiro-Wilk ou Levene, respectivamente. A principal desvantagem da ANOVA consiste na falta de identificação de quais grupos específicos diferem entre si, ou ainda na dificuldade de verificar quais são estatisticamente iguais ou diferentes. Neste caso, uma abordagem muito útil que possibilita julgar se as médias são iguais ou não, e que é amplamente utilizada, é o teste de Tukey HSD (do inglês: honest significant difference).40 O HSD de Tukey é um teste post-hoc comumente utilizado após a realização da ANOVA e é muito útil para verificar diferenças significativas entre as médias de três ou mais grupos em uma série de experimentos químicos.

INTERFACE GRÁFICA Neste segundo tutorial, serão realizadas aplicações práticas utilizando outras interfaces do aplicativo GAMMA-GUI. O aplicativo, juntamente com os conjuntos de dados usados como demonstração neste tutorial, está disponível para download no GitHub20 ou no file Exchange da MathWorks.19 Para a instalação do GAMMA-GUI utilizando a opção do GitHub, os usuários devem consultar as instruções no nosso primeiro tutorial.17 A instalação utilizando a versão do File Exchange é mais simples e pode ser realizada diretamente no Matlab. Para isso, basta que os usuários abram o arquivo executável baixado do site do file Exchange. Após o processo de instalação, o aplicativo pode ser executado ao apertar o botão "GAMMA" na aba "APPS" do Matlab, conforme o vídeo de instalação.41 O aplicativo foi testado nas versões do software Matlab R2022a a R2024a. Para sua íntegra utilização, requer funções dos toolboxes "Global Optimization Toolbox", "Optimization Toolbox", "Statistics Machine Learning Toolbox", "Bioinformatics Toolbox" e "Signal Processing Toolbox". Para usuários que não têm acesso à licença do Matlab, alguns recursos do aplicativo GAMMA-GUI podem ser utilizados através da versão online do Matlab (observação: nessa modalidade, o uso é restrito ao ambiente online, com um limite de 20 h mensais de utilização). O processo começa com a criação de uma conta no site da MathWorks42 utilizando um e-mail institucional. Em seguida, basta fazer o download e a instalação do aplicativo através da aba "APPS" no Matlab Online, conforme as instruções detalhadas disponíveis em nosso Instagram.43 Conhecendo as interfaces do GAMMA-GUI Na interface "Visualização e pré-tratamentos", os usuários têm a possibilidade de realizar a visualização, manipulação e pré-tratamento de dados (Figura 1Sa, Material Suplementar). Nessa interface, os usuários podem plotar os dados, selecionar variáveis, excluir amostras ou ainda aplicar diferentes algoritmos de pré-processamentos nos dados. Existem diversas opções de algoritmos disponíveis na literatura, e no GAMMA-GUI os usuários têm as principais metodologias para análise multivariada, entre elas o alisamento pela média móvel, com filtro de Savitsky-Golay e Spline alisadora, técnicas de derivadas, correção de sinal MSC (multiplicative scatter correction) e SNV (standard normal variate), correção de linha de base e interpolação. Enquanto na interface "Análise Exploratória", os usuários têm a possibilidade de utilizar diferentes estratégias não supervisionadas de análises de dados, tais como HCA, PCA, SOM, k-means e ComDim (Figura 1Sb, Material Suplementar).

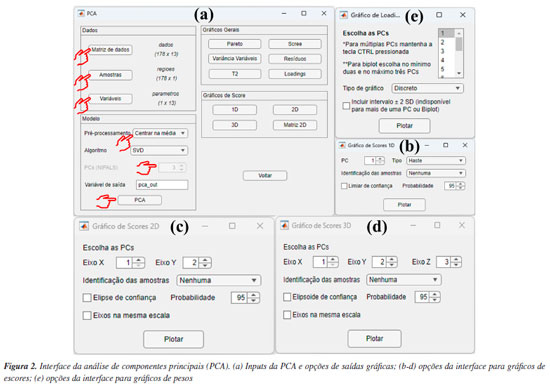

DEMONSTRAÇÕES USANDO O GAMMA-GUI Neste segundo artigo tutorial, concentramos nossas demonstrações usando as interfaces "Análise Exploratória" e "Visualização e pré-tratamentos". Para isso, diferentes conjuntos de dados foram selecionados do banco de dados do Matlab, dos autores e da literatura para demonstrar as aplicabilidades e funcionalidades do aplicativo. Neste tutorial, fornecemos aos usuários um passo a passo dos procedimentos adequados que devem ser seguidos para a análise não supervisionada de dados, assim como a interpretação dos resultados obtidos, utilizando uma interface gráfica amigável e livre de programação. Cabe ainda salientar que recursos extras do uso do aplicativo podem ser encontrados em nosso canal no YouTube, através de vídeos tutorias.18 Ressaltamos também que a utilização do GAMMA-GUI por usuários iniciantes também é recomendada e fomentada pelos desenvolvedores do aplicativo, desde que os usuários busquem alguns conhecimentos prévios sobre o assunto antes da sua utilização. PCA Adiante, demonstramos passo a passo como realizar e interpretar os resultados da PCA. Entretanto, é fundamental que, antes da etapa de análise, os usuários organizem os dados da matriz X da seguinte maneira: as linhas devem ser compostas pelas amostras e as colunas pelas variáveis. Nesse exemplo demonstrativo, utilizamos um conjunto de dados que consiste em 13 parâmetros físico-químicos determinados de 178 amostras de vinhos de diferentes regiões vinícolas italianas denominadas: Barolo (O), Grignolino (G) e Barbera (E).44 A matriz X para esse conjunto de dados é dada por I linhas que correspondem às amostras de vinhos × J colunas correspondem aos parâmetros físico-químicos, gerando uma matriz com dimensões 178 × 13, disponível no material de demonstração "dados_vinho" e YouTube.45 Ao carregar o material de demonstração no Matlab, os usuários terão acesso a uma série de estruturas disponíveis no workspace, como a matriz "dados", que contém os valores dos parâmetros físico-químicos determinados nos vinhos; três vetores de caracteres "nomes", "regioes" e "parametros", que contêm, respectivamente, os nomes completos das regiões vinícolas, as regiões vinícolas abreviadas de cada amostra de vinho e os nomes dos parâmetros físico-químicos determinados. Nesta demonstração, optamos por abreviar os nomes das regiões vinícolas para facilitar a interpretação e a visualização nas saídas gráficas da PCA. Iniciaremos a análise abrindo a janela "Análise Exploratória" do GAMMA-GUI e apertando o botão "PCA". Após essa etapa, uma nova janela se abrirá, onde os usuários precisam definir os inputs para realizar a análise, selecionando a matriz de dados e os vetores que identificam as amostras e variáveis na interface do aplicativo, utilizando os botões "Matriz de dados", "Amostras" e "Variáveis", conforme mostrado na Figura 2a. Ao apertar cada um desses botões, uma nova janela "Selecione as variáveis" será aberta, e, em cada uma delas, os usuários precisam definir adequadamente a matriz de dados e os vetores que identificam as amostras e variáveis. Neste caso, após apertar o botão "Matriz de dados", a estrutura "dados" deve ser selecionada, no botão "Amostras" selecionar "regioes" e, em "Variáveis", selecionar "parametros", como ilustrado na Figura 2a. Cabe ainda salientar que os vetores que identificam as amostras e variáveis devem estar no formato "cell array", onde cada célula pode conter qualquer tipo de dado. Aqui, essas estruturas contêm as informações dos nomes abreviados das regiões vinícolas italianas, representadas pelo vetor "regioes", e nomes dos parâmetros físico-químicos (álcool, ácido málico, cinzas, alcalinidade das cinzas, magnésio, fenólicos totais, flavonoides, fenólicos não flavonoides, proantocianidinas, intensidade de cor, matriz de coloração "hue", oxigênio dissolvido e prolina), representados pelo vetor "parametros".

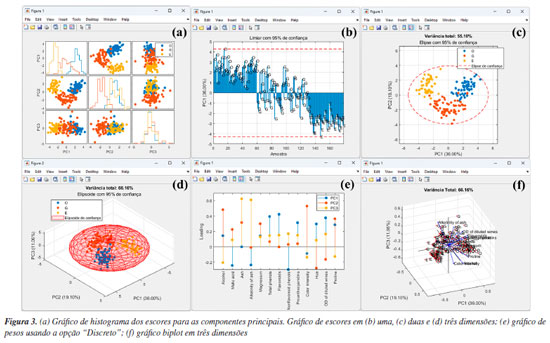

Na etapa seguinte, os usuários devem definir o tipo de pré-tratamento que será aplicado nas variáveis - colunas da matriz X usando o botão "Pré-processamento". Esse procedimento é essencial em qualquer análise quimiométrica, pois facilita a detecção e identificação de padrões e características relevantes nos conjuntos de dados químicos.1 Entre as opções de pré-tratamentos, o autoescalamento e a centragem na média estão entre os mais usuais. Neste exemplo, o autoescalamento é o procedimento mais recomendável, pois as variáveis têm diferentes unidades ou amplas faixas de variações. Nesses casos, ao aplicar esse procedimento, iguala-se o impacto entre as variáveis, ou seja, dá-se a mesma importância para todas as variáveis do conjunto de dados. Para a seleção do tipo de pré-tratamento no GAMMA-GUI, os usuários devem selecionar no botão "Pré-processamento", e escolher a opção "Autoescalamento". Agora, se o objetivo do usuário for avaliar dados espectrais, é preferível a aplicação da opção "Centragem na média", pois, ao centralizar os dados na média, a estrutura dos dados é preservada e a direção de maior dispersão ao redor dessa média coincide com a direção de maior variância interna dos dados, ou seja, as coordenadas são movidas para o centro dos dados, permitindo que as diferenças entre as variáveis se tornem mais perceptíveis.3,23,30 Existem ainda outras estratégias de pré-tratamentos, tais como o escalamento pela variância, pela amplitude, e variações de autoescalamento, como o autoescalamento de Pareto, VAST (variable stability) e nivelamento, entre outros.3 Além das etapas de pré-tratamento aplicadas às colunas da matriz X, existe ainda a possiblidade de pré-tratamento aplicado às linhas da matriz X, ou seja, às amostras que compõem o conjunto de dados. Estudos que envolvem dados espectrais, na maioria dos casos, requerem determinadas etapas de pré-processamento com o uso de algoritmos específicos. Frequentemente, estas etapas são aplicadas para minimização de informações indesejadas em dados espectroscópicos, como a correção do deslocamento da linha de base e fase/inclinação, correção de efeitos de espalhamentos em espectros de infravermelho próximo ou médio, ou variações em espectros de Raman e UV-Vis, ou ainda correções de deslocamentos em espectros de RMN ou cromatogramas desalinhados, entre outros tipos de correções existentes. Maiores detalhes podem encontrados na obra de Ferreira.3 Caso os usuários necessitem aplicar tais recursos em seus dados, na interface "Visualização e pré-tratamentos" do GAMMA-GUI (Figura 1Sa), os usuários têm a disponibilidade de escolher opções de alisamento, derivadas, correção de sinal, linha de base e interpolação de dados. Entretanto, se os usuários precisarem alinhar os dados no eixo das ordenas, como frequentemente é requerido em espectros de RMN ou cromatogramas, uma ótima ferramenta é o icoshift (interval-correlation-shifting),46 um algoritmo de código aberto para Matlab, disponibilizado para download em Chemometrics Research.47 A etapa seguinte consiste em definir o algoritmo e o número de componentes principais usando os botões "Algoritmo" e "PCs", respectivamente. No GAMMA-GUI, os usuários têm disponível as opções "SVD" (singular value decomposition) ou "NIPALS" (nonlinear iterative partial least squares) para o cálculo das matrizes de escores e de pesos. Neste exemplo, escolhemos o SVD, pois é considerada uma opção mais acurada e estável para cálculos das componentes principais. Para aplicações em que a matriz X possui muitas colunas e um posto químico pequeno (ou seja, alta correlação entre as variáveis), o NIPALS é recomendável, pois os vetores dos pesos e dos escores são calculados iterativamente, um de cada vez, o que reduz o tempo e esforço necessários para o processamento dos dados.3,23,30 O NIPALS é particularmente indicado para conjuntos de dados muito grandes, especialmente quando a análise é realizada em sistemas computacionais mais modestos, nos quais a decomposição SVD pode exigir uma quantidade elevada de memória. Para o algoritmo SVD, serão calculadas todas as PCs possíveis. Após a definição das etapas anteriores, é hora de realizar a análise, apertando o botão "PCA". Se os usuários desejarem, na caixa "Variável de saída", têm a liberdade de criar suas próprias nomenclaturas. Contudo, como default, a estrutura de saída dos dados é definida como "pca_out". Na estrutura de saída "pca_out" (default), os usuários têm à disposição uma série de recursos, como o acesso a matriz de escores "T", matriz de pesos "P", matriz de resíduos "Residuos", variância explicada "explained", teste de Hotelling's "T2" (mais informações sobre T2 são fornecidas adiante), entre outros. Os usuários também podem ainda gerar gráficos, acessando as opções "Gráficos Gerais" e "Gráficos de Score", ver Figura 2. Algumas opções de "Gráficos Gerais" estão ilustradas na Figura 2S (Material Suplementar), como o gráfico de "Pareto" (Figura 2Sa), "Scree" (Figura 2Sb), "Variância Variável" (Figura 2Sc) e "T2" (Figura 2Sd). Existe ainda, a opção de plotar o gráfico de resíduos, que não é demonstrado neste exemplo. A análise simultânea dos gráficos das Figuras 2Sa e 2Sb possibilita a definição do "posto químico" da matriz, ou seja, o número mínimo de novas variáveis capazes de descrever a máxima informação dos dados originais após a compressão. Essas novas variáveis são denominadas componentes principais, ou ainda fatores ou autovetores.3 De acordo com a Figura S2b, os autovalores apresentam uma redução significativa a partir de quatro a cinco PCs. Para este conjunto de dados, utilizamos também o conhecimento prévio do problema para determinar o número de A PCs a serem consideradas. Sabemos que há três origens geográficas distintas para os vinhos, o que nos permite, inicialmente, assumir que três PCs poderiam ser suficientes para diferenciar entre esses grupos, uma para cada região vinícola. É importante destacar, no entanto, que isso não significa que três PCs sejam suficientes para descrever toda a variabilidade do conjunto de dados. Elas podem, contudo, ser adequadas para a tarefa específica de diferenciar as amostras com base na região de origem, desde que carreguem informação relevante para essa distinção. Vale lembrar que as PCs são determinadas com base na maximização da variância dos dados, e não na separação entre classes. Portanto, a separação entre os três tipos de vinho nas três primeiras PCs só é possível porque as variáveis medidas contêm, de fato, informações discriminantes relacionadas à origem geográfica, enquanto as outras PCs descrevem outras informações que nos interessam no momento. Os valores de variâncias das PCs são cumulativos. Neste caso, a PC1 teve uma variância de 35,99%, PC2 de 19,09% e PC3 de 11,06%, totalizando uma variância de 66,15% da informação original dos dados, ver Figura 2Sa. Na Figura 2Sc, os usuários podem ainda verificar a contribuição de cada variável (neste caso, os parâmetros físico-químicos) em uma dada PC. Neste estudo, os flavonoides, fenóis totais e oxigênio dissolvido foram as variáveis/parâmetros que mais contribuíram na PC1, a intensidade de cor e teor de álcool na PC2, cinzas e alcalinidade das cinzas na PC3, e assim por diante. Em estudos com um número elevado de variáveis, como em dados espectrais, essa interpretação não é trivial. A matriz de resíduos E na PCA possibilita a estimativa de parâmetros estatísticos fundamentais para a análise dos dados. Na estrutura de saída "pca_out", ao acessar "Residuos", os usuários têm acesso a matriz de resíduos em "Res", o parâmetro "Q", que mede o quão bem cada amostra se ajusta ao novo subespaço definido pelas A PCs. Esse parâmetro é calculado pela soma quadrática dos elementos de cada linha da matriz E.3 Além disso, o "Xprev" é uma estimativa da matriz X nas A PCs definidas. Ao apertar o botão "Resíduos", os usuários podem facilmente verificar graficamente a distribuição dos resíduos das amostras para cada PC, gráfico não mostrado. Outro recurso fundamental é a possibilidade de detecção de amostras anômalas "outliers", isto é, identificar amostras que tenham comportamentos atípicos dentro do conjunto de dados. Existem várias estratégias estatísticas que viabilizam a identificação de amostras anômalas, no GAMMA-GUI as estimativas são obtidas usando o teste de Hotelling's (T2), que é uma extensão do teste t de Student para múltiplas variáveis. No GAMMA-GUI, a análise é baseada na estatística T2 de Hotelling, utilizando a distância de Mahalanobis como medida de cálculo. Essa distância é comparada a um limite crítico (α), sendo o valor resultante usado como critério para detectar amostras outliers no espaço da PCA, com base na estatística T2 calculada a partir da distribuição F. Embora a estatística T2 de Hotelling e a distância de Mahalanobis sejam conceitualmente distintas, elas tornam-se matematicamente equivalentes no contexto específico da PCA, quando os dados estão centrados na média, projetados em componentes principais ortogonais, e padronizados pela divisão pelas raízes quadradas dos respectivos autovalores (1/√λi). Essa equivalência numérica ocorre porque, neste espaço transformado, a matriz de covariância dos componentes principais padronizados se reduz exatamente à matriz identidade.1 O teste T2 mede o desvio de cada observação dentro do espaço PCA, e consiste em determinar as probabilidades de uma amostra pertencer a um grupo específico para um dado nível de confiança (α).6 Se o valor calculado da estatística T2 for maior que um valor crítico, sugere-se a presença de amostra outlier.1 Mais detalhes nos trabalhos de Varmuza e Filzmoser,1 Brereton6 e Gemperline.48 Apertando o botão "T2", ou ainda acessando a estrutura de saída de dados "T2" em "pca_out", os usuários podem evidenciar a existência de possíveis outliers considerando as primeiras A componentes principais para um dado nível de significância. De acordo com a Figura 2Sd, neste caso, é possível verificar cinco possíveis outliers com base na projeção no espaço PCA com as três primeiras PCs ao nível de 95% de confiança, uma amostra de vinho Barolo (O) e quatro Grignolino (G). Amostras anômalas podem ocorrer por diversas razões, e devem ser verificadas caso a caso pelo analista, que a posteriori deve tomar a decisão de excluí-la ou não do conjunto de dados. Caso o usuário almeje excluir uma amostra do conjunto de dados, o botão "Excluir amostras" na interface "Visualização e pré-tratamentos" pode ser utilizado. Os gráficos mais importantes para interpretação dos resultados da PCA são o gráfico de escores, que projeta as amostras no eixo das componentes principais, e o gráfico de pesos, que indica o quanto cada variável original contribuiu para a formação das componentes principais. Outro recurso interessante é o gráfico biplot, que combina os escores e os pesos, podendo ser gerado em duas ou três dimensões. Os gráficos da Figura 3 resumem os resultados deste estudo usando as três primeiras PCs.

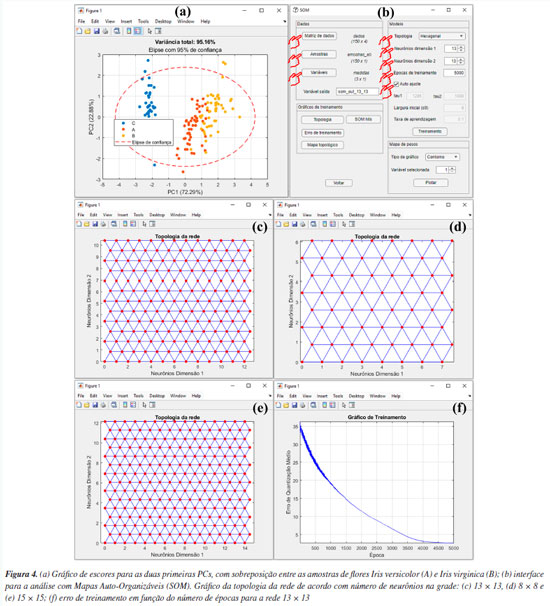

É recomendável iniciar a análise dos resultados da PCA através da análise dos gráficos de escores. Os usuários têm a possibilidade de gerar gráficos de escores em uma "1D", duas "2D" ou três dimensões "3D", ver Figuras 2b, 2c e 2d, ou ainda uma matriz de gráficos 2D com as possíveis combinações binárias das PCs escolhidas, ver Figura 3a. Os gráficos de escores são representações gráficas que indicam as projeções das amostras no novo sistema de coordenadas de dimensões reduzidas (PCs). Neste exemplo, nos limitamos à interpretação usando apenas as três primeiras componentes principais, conforme mostrado nas Figuras 3b-3d. No entanto, os usuários podem criar suas próprias combinações de gráficos de escores utilizando componentes principais de ordem superior. Durante a construção dos gráficos, os usuários podem ainda incluir os limiares de confiança para um nível de probabilidade α, marcando a caixa "Limiar de confiança", "Elipse de confiança" ou "Elipsoide de confiança" nos gráficos de uma, duas ou três dimensões, respectivamente. Nos gráficos de escores do GAMMA-GUI, os usuários podem optar por calcular limiares de confiança univariados baseados na distribuição F de Fisher: limites em 1D, elipses em 2D e elipsoides em 3D para cada PC, na PCA. Essa abordagem, de aplicação mais simples, permite verificar se os escores individuais estão dentro do intervalo esperado, considerando a variância explicada por cada PC avaliada. Além disso, é possível padronizar as escalas dos eixos nos gráficos de duas ou três dimensões marcando a caixa "Eixos na mesma escala", ou ainda escolher diferentes modos de identificação das amostras por cor, números ou nomes usando a caixa "Identificação das amostras". Na Figura 3b, é notável que a PC1 possibilitou diferenciar os vinhos Barolo (O) dos vinhos Barbera (E), enquanto os vinhos Grignolino (G) tem propriedades físico-química intermediárias entre os vinhos Barolo (O) e Barbera (E). Já a PC2 (gráfico 1D não mostrado) é fundamental para diferenciar os vinhos Grignolino (G) dos vinhos Barolo (O) e Barbera (E), sendo essa separação visível na Figura 3a. As Figuras 3c e 3d mostram os gráficos de escores para as duas e três primeiras PCs, respectivamente. Estes gráficos permitem uma melhor compreensão da diferenciação previamente relatada. Claramente evidencia-se a diferenciação entre os vinhos das diferentes regiões vinícolas italianas nas três primeiras PCs. Na opção "Loadings", o usuário pode plotar os gráficos de pesos de diferentes modos: "Discreto", "Linhas" ou "Biplot", conforme as opções na Figura 2e. A Figura 3e é uma representação da influência/pesos em termos da magnitude positiva ou negativa para uma variável em uma determinada componente principal. Neste caso, os pesos estão associados aos parâmetros físico-químicos avaliados. Para resumir, faremos uma discussão de apenas duas variáveis na PC1, porém, em uma análise real, é fundamental verificar e interpretar os resultados das demais PCs e de todas as variáveis. Tomando como exemplo os pesos de cada parâmetro na PC1, nota-se que os flavonoides apresentam o maior peso positivo, enquanto os compostos fenólicos não flavonoides tiveram o maior peso negativo. Ou seja, os teores de compostos fenólicos flavonoides e não flavonoides apresentam um maior peso para a diferenciação entre os vinhos de diferentes regiões vinícolas italianas na PC1. Associando a informação dos pesos ao gráfico de escores na PC1, é possível concluir que os vinhos Barolo (quadrante positivo da PC1) são mais ricos em compostos flavonoides, enquanto os vinhos Barbera (quadrante negativo da PC1) possuem um teor maior de fenólicos não flavonoides. Portanto, o sinal positivo ou negativo do peso, em conjunto com o sinal do escore, nos auxilia a identificar quais amostras têm um valor maior ou menor de uma determinada variável. Uma representação mais abrangente dos resultados da PCA é dada pelo gráfico biplot, que é uma representação conjunta dos pesos e escores em duas ou três dimensões. Na Figura 3f, temos o gráfico biplot para as três primeiras PCs. Neste caso, é notável a diferenciação entre os grupos de vinhos das diferentes regiões vinícolas italianas, sendo que a maioria dos vinhos Barbera (E) encontra-se no quadrante esquerdo do gráfico, os vinhos Barolo (O) no quadrante direito, e os vinhos Grignolino (G) no centro do gráfico. Tal diferenciação entre os vinhos deve-se fundamentalmente à influência, representada pelas linhas azuis na área do gráfico, que indicam os pesos de cada parâmetro, como teor de ácido málico e compostos fenólicos não flavonoides nas amostras de vinhos Barbera, flavonoides, fenóis totais e proantocianidinas nos vinhos Barolo, e matriz de coloração "hue" e oxigênio dissolvido nos vinhos Grignolino. SOM Neste exemplo, utilizamos o famoso conjunto de dados de flores Iris, publicado pelo estatístico e biólogo britânico Ronald Fisher.49 Este conjunto de dados é composto por 150 amostras, divididas igualmente entre três espécies: Irisversicolor (A), I. virginica (B) e I. setosa (C). Cada amostra teve quatro características taxonômicas medidas: comprimento da sépala, largura da sépala, comprimento da pétala e largura da pétala, em centímetros. A matriz de dados X para esse conjunto de dados é composta por I linhas (amostras de flores) e J colunas (características taxonômicas), resultando em uma matriz com dimensões 150 × 4, disponível no material de demonstração "dados_iris" e YouTube.50 Ao carregar o material de demonstração no Matlab, os usuários terão a matriz "dados", contendo os valores das medidas obtidas para todas as amostras, e três vetores de caracteres: "amostras", "amostras_ab" e "medidas", que correspondem, respectivamente, aos nomes das espécies botânicas de cada amostra, à nomenclatura abreviada criada para as amostras e às características taxonômicas medidas. Novamente, optamos por criar um vetor com os nomes abreviados para facilitar a interpretação e a visualização das saídas gráficas do SOM. Antes de iniciarmos a análise dos dados, precisamos esclarecer aos usuários alguns pontos fundamentais. O SOM é utilizado com uma finalidade semelhante à PCA; ambos permitem a redução da dimensionalidade do conjunto de dados, sendo que cada um apresenta suas vantagens e limitações. O SOM visa organizar dimensionalmente dados complexos, formando grupos de acordo com suas relações organizando-os em uma estrutura espacial chamada "mapa topológico", tradicionalmente uma grade bidimensional 2D. Enquanto na PCA não há nenhuma definição a priori da quantidade de dimensões (PCs) necessárias para representar os dados. Outra distinção fundamental entre ambos está na capacidade do SOM em lidar com conjuntos de dados caracterizados por comportamentos não lineares altamente complexos.24,28,51,52 Em outras palavras, o SOM pode capturar e representar melhor padrões complexos e não lineares presentes nos dados de forma mais fidedigna do que à PCA. Entretanto, o SOM requer conjuntos de dados substancialmente maiores, o que pode torná-lo mais suscetível ao overfitting quando aplicado em conjuntos de dados pequenos, ao contrário da PCA que não é susceptível a tais limitações. Outra desvantagem do SOM é o maior tempo computacional para análise dos dados e a necessidade de ajuste de uma quantidade maior de parâmetros do modelo, em comparação à PCA. Aconselhamos que os usuários priorizem abordagens mais simples, robustas e usuais como a PCA. Se tais abordagens não forem capazes de atender aos requisitos específicos ou de fornecer os resultados desejados, é recomendável que os usuários busquem considerar outras opções de análise de dados.4 Neste exemplo, iniciamos a análise do conjunto de dados de flores Iris seguindo as etapas descritas na seção anterior, utilizando à PCA, um modelo quimiométrico robusto, simples, de fácil implementação e com amplo potencial de aplicação. Em seguida, buscamos diferenciar as amostras utilizando um modelo de aprendizagem baseado em SOM, como uma alternativa complementar. Tradicionalmente, o conjunto de dados Fisher49 tem sido utilizado para propor novos algoritmos de aprendizado de máquina supervisionados, nos quais os modelos são construídos a partir de dados rotulados a priori. Seu uso para aprendizagem não supervisionados não é comum, uma vez que as amostras de Iris versicolor (A) e Iris virginica (B) não são facilmente separáveis usando esses modelos,52 conforme podemos visualizar nos resultados da PCA na Figura 4a. Em comparação, empregamos à análise discriminante linear (linear discriminant analysis, LDA), que possibilitou a classificação das três espécies de Iris com 100% de acurácia de predição. Entretanto, esses resultados não são explorados em profundidade neste tutorial, uma vez que o foco principal é a aprendizagem não supervisionada.

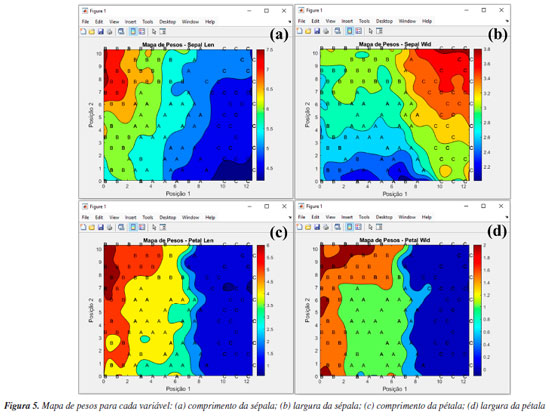

Para gerar o modelo de aprendizagem, aperte o botão "SOM" na janela "Análise Exploratória" do GAMMA-GUI. Após essa etapa, uma janela semelhante à Figura 4b se abrirá, e, nesta janela, os usuários precisam definir os inputs para realizar a análise, definindo a matriz de dados e os vetores que identificam as amostras e variáveis na interface do aplicativo, através dos botões "Matriz de dados", "Amostras" e "Variáveis", semelhante ao procedimento descrito anteriormente na seção da PCA. Após apertar o botão "Matriz de dados", a matriz "dados" deve ser selecionada, no botão "Amostras", selecionar "amostras_ab" e, em "Variáveis", selecionar "medidas". Em seguida, os usuários precisam definir alguns parâmetros específicos do SOM, como o tipo da topologia da rede usando o botão "Topologia", número de neurônios em cada uma das dimensões da rede, em "Neurônios dimensão 1" e "Neurônios dimensão 2", a quantidade de épocas de treinamento, em "Épocas de treinamento", e, por fim, marcar a caixa "Auto ajuste", de acordo com a Figura 4b. Para usuários mais experientes, ao desmarcar a caixa "Auto ajuste", outros parâmetros podem ainda ser ajustados. Para mais detalhes destes parâmetros, os leitores podem consultar Haykin.51 Por exemplo, a taxa de aprendizagem da rede, na caixa "Taxa de aprendizagem", é um parâmetro que controla o quanto os pesos dos neurônios são ajustados em cada iteração. Segundo Haykin,28 é recomendável usar uma taxa de aprendizagem inicial com um valor próximo de 0,1; portanto, o GAMMA-GUI tem como default esse valor de taxa de aprendizagem. Agora é hora de realizar a análise dos dados, apertando o botão "Treinamento", que, após finalizada, fornecerá uma estrutura de saída que renomeamos para "som_out_13_13". A fim de poupar o tempo de análise dos dados, neste material de demonstração os usuários têm acesso aos resultados de três opções de saídas de rede, em diferentes configurações, nomeadas como: "som_out_8_8", "som_out_13_13" e "som_out_15_15", que correspondem às topologias de dimensões 8 × 8, 13 × 13 e 15 × 15, respectivamente (Figuras 4c, 4d e 4e). Nestes gráficos, os pontos vermelhos representam os neurônios distribuídos na grade, enquanto as linhas azuis indicam as conexões de vizinhança entre eles. No interior da grade, cada ponto (neurônio) se conecta aos seus vizinhos que os cercam, formando uma estrutura chamada topologia. Neste caso, hexagonal, pois o padrão resultante se assemelha a hexágonos. No entanto, nas bordas e nos cantos da grade, os neurônios possuem menos conexões, pois nem todos os seis vizinhos estão disponíveis. A mesma linha de raciocínio é válida para a topologia retangular. Conforme antecipado, definir os parâmetros do SOM na maioria das vezes, não é uma tarefa trivial e pode exigir uma série de tentativas, mas algumas abordagens facilitam na sua definição, conforme demonstraremos. Durante a escolha da topologia da rede, os usuários devem priorizar uma estrutura de grade hexagonal se os dados tiverem uma distribuição mais isotrópica, ou escolher uma estrutura de grade retangular se os dados tiverem uma distribuição mais linear. Neste exemplo, escolhemos a topologia hexagonal, pois conforme vimos anteriormente, a PCA (técnica linear) não foi suficiente para diferenciar com clareza as três espécies de flores, ver Figura 4a. Outro parâmetro que deve ser ajustado é a quantidade de neurônios na grade, o que altera o tamanho da rede. Esse ajuste deve ser feito testando diferentes quantidades de neurônios. Uma boa opção é iniciar a análise usando uma quantidade de neurônios próximo ao número de amostras. Neste caso, temos 150 amostras, portanto, iniciaremos os testes com uma rede bidimensional 13 × 13. Ao apertar o botão "Topologia", após o treinamento da rede, os usuários podem gerar o gráfico da topologia da rede, que, neste caso, consiste em uma rede com 169 neurônios (Figura 4c). Para verificar se o tamanho da rede é ideal, os usuários podem comparar os comportamentos de distribuição das amostras com redes menores ou maiores (conforme veremos adiante). Neste caso, comparamos os resultados com uma rede 8 × 8, que contém 64 neurônios (Figura 4d), e uma rede 15 × 15, que contém 250 neurônios (Figura 4e). Após a etapa de treinamento da rede, os usuários podem gerar o gráfico de erro de treinamento da rede usando o botão "Erro de treinamento" (Figura 4f). Além das opções gráficas, os usuários podem acessar uma série de outros resultados da análise nas estruturas de saída dos dados, neste caso nomeadas como "som_out_8_8", "som_out_13_13" e "som_out_15_15", disponíveis no material demonstrativo deste tutorial. O gráfico de erro de treinamento auxilia os usuários na definição do número de épocas de treinamento, ou seja, o número de vezes que o conjunto de dados de treinamento é apresentado à rede. Ao utilizar um número elevado de épocas, a rede pode sofrer overfitting, memorizando os dados de treinamento em vez de aprender novos padrões, diminuindo a capacidade de generalização. Se o número de épocas for baixo, pode ocorrer o underfitting.28,53 Na rede 13 × 13 testada, o erro de quantização no gráfico decresce com o aumento do número de épocas (Figura 4f), e, após 4000 épocas, o erro de quantização atinge um estado estacionário. Esse platô no gráfico indica que os neurônios no mapa estão próximos de representar corretamente os padrões de entrada observados. Portanto, as 5000 épocas definidas na caixa "Épocas de treinamento" foram suficientes para esse conjunto de dados. Caso um platô não seja atingido, seria apropriado considerar o treinamento de uma nova rede com um número maior de épocas. Por outro lado, se um platô for alcançado com menos épocas, os usuários podem optar por utilizar menos épocas, resultando em uma redução considerável no tempo de treinamento da rede. O mapa topológico é uma das principais representações gráficas do SOM, permitindo visualizar a distribuição das amostras de acordo com o neurônio vencedor. No botão "Mapa topológico" do GAMMA-GUI, existem diversas opções de gráficos para os dados, como o uso da caixa de identificação das amostras por "Numeração" ou "Grupos", e a caixa de seleção das amostras a serem plotadas, que podem ser "Todas as amostras" ou grupo específico das amostras que se deseja plotar, neste caso "A", "B" ou "C". Além disso, os usuários podem ainda incluir a topologia da rede no mapa topológico, marcando a caixa "Incluir topologia". Nas Figuras 3Sa-3Sc (Material Suplementar), temos os mapas topológicos para as três configurações testadas. Nestes gráficos, cada amostra do conjunto de dados está associada a um respectivo neurônio "vencedor", ou seja, aquele neurônio que melhor o representa na rede. Por ser uma técnica aglomerativa não supervisionada, o SOM organiza os dados de entrada como clusters, que podem ser formados por um ou mais neurônios. A definição de clusters é caracterizada pela presença de neurônios vazios entre os grupos. Clusters próximos compartilham semelhanças; ou seja, quanto maior a distância euclidiana, maior a diferença entre os clusters.54 Interpretando os resultados do SOM para esse conjunto de dados, obtidos com diferentes tamanhos de rede, nota-se que as amostras de Iris tendem a formar clusters. Comparando o perfil de distribuição das amostras entre as redes de 13 × 13 e 8 × 8 nas Figuras 3Sa e 3Sb, percebe-se que a redução no tamanho da rede resulta em uma significativa sobreposição das amostras A, B e C nos mesmos neurônios. Isso sugere fortemente que um aumento no tamanho da rede é indicado para melhorar a representação dos dados, evitando a perda de informações devido à superposição excessiva de amostras diferentes no mesmo neurônio. Ao comparar a distribuição entre as redes de 13 × 13 e 15 × 15 das Figuras 3Sa e 3Sc, observa-se que o aumento no tamanho da rede resultou apenas em uma maior dispersão das amostras no mapa, sem melhoria no agrupamento das classes de Iris. Essas comparações sugerem que uma rede de tamanho 13 × 13 é apropriada, indicando que o aumento da rede não trouxe benefícios adicionais. Conforme observado na Figura 3Sa, há uma certa diferenciação entre as três espécies de flores Iris. No entanto, assim como ocorreu na análise PCA, ainda existe alguma sobreposição entre as amostras de Iris versicolor (A) e Iris virginica (B). Nota-se que, à direita do mapa, identificamos claramente a formação de um cluster representado pelas flores Iris setosa (C), no centro encontra-se o cluster majoritariamente composto pelas flores Iris versicolor (A), e à esquerda do mapa o cluster formado pelas flores Iris virginica (B). Esse resultado demonstra que os desempenhos obtidos com o SOM podem ser comparáveis aos da PCA. No entanto, as abordagens de análise de dados aplicadas são totalmente distintas, sendo a PCA um modelo quimiométrico e o SOM um modelo de aprendizagem. Outra saída gráfica do SOM é o mapa de hits. Ao clicar no botão "SOM hits", o usuário pode visualizar um gráfico que contabiliza quantas amostras foram atribuídas a cada "neurônio vencedor" (Figura 3Sd). Já o mapa de pesos é uma representação visual indicada por escalas de cores no gráfico, que associa o mapa topológico à segmentação das amostras, baseada nos pesos dos neurônios em relação às variáveis de entrada, de forma semelhante aos pesos na PCA. Neste gráfico, cada neurônio na rede possui um vetor de pesos que define sua resposta a determinados padrões nos dados de entrada. Assim, a interpretação de um mapa de pesos envolve analisar como esses vetores estão distribuídos no espaço do mapa e representados pela escala de cores.54 No GAMMA-GUI, os usuários têm a capacidade de escolher o tipo de mapa de pesos que desejam criar através da opção "Tipo de gráfico". Ao escolher "Contorno", serão gerados gráficos em duas dimensões, enquanto a seleção de "Superfície" resultará em gráficos em três dimensões. Um mapa de peso é gerado para cada variável. Portanto, basta que o usuário ajuste em "Variável selecionada" qual variável deseja analisar e, em seguida, apertar o botão "Plotar". Neste exemplo, as variáveis são as quatro características taxonômicas medidas: comprimento da sépala, largura da sépala, comprimento da pétala e largura da pétala. Assim, quatro mapas de pesos em duas dimensões foram gerados (Figuras 5a-5d). Os usuários também podem criar os mapas de pesos em três dimensões (não mostrado).

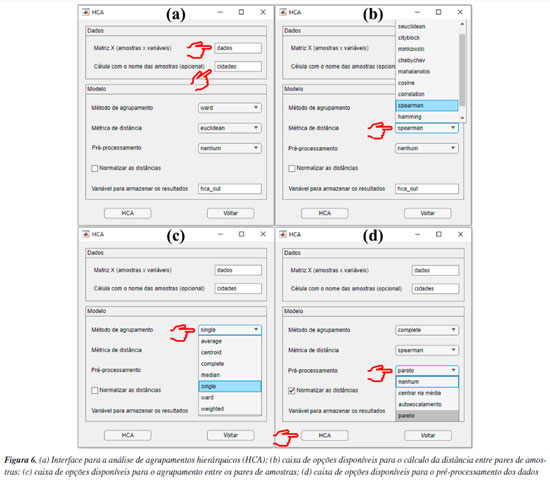

Analisando os mapas de pesos das Figuras 5a-5d, observa-se que as amostras de Iris setosa (C) na maioria dos casos exibem pesos menores em comparação com as amostras de Iris versicolor (A) e Iris virginica (B), enquanto as amostras de Iris virginica (B), por sua vez, demonstram pesos superiores às amostras de Iris versicolor (A). Essa distribuição heterogênea dos pesos no mapa para cada classe de amostras de flores significa que as quatro variáveis podem influenciar na formação dos clusters. No entanto, é notável que, entre as quatro variáveis analisadas, a largura e o comprimento da pétala foram as variáveis mais importantes. Isso é possível ao observar a escala de cores, para diferenciar claramente as três espécies de flores Iris. Tal comportamento não é observado para a largura da sépala (Figura 5b), uma vez que, segundo a escala de cores, não é possível evidenciar com clareza a diferenciação entre as espécies de flores. Uma abordagem alternativa consiste em realizar o treinamento de uma nova rede utilizando as mesmas configurações, porém removendo a variável "largura da sépala" do conjunto de dados para tentar melhorar a diferenciação entre as amostras. Tal abordagem também é aplicada na PCA, quando uma variável prejudica a diferenciação das amostras. De acordo com a Figura 4S (Material Suplementar), observa-se que, ao utilizar o conjunto de dados "som_out_13_13_sem_var2", isto é, a coluna da matriz que corresponde à largura da sépala, o perfil de diferenciação entre as três espécies de Iris teve uma ligeira melhora comparada à análise anterior. Para concluir esta seção, gostaríamos de ressaltar que a inclusão do SOM neste tutorial tem como principal objetivo apresentar uma alternativa entre várias possíveis para a análise exploratória de dados, podendo complementar a PCA. Nosso foco é mostrar como executar e interpretar os resultados do SOM, uma abordagem ainda pouco usual na quimiometria. Isso não significa que o SOM seja melhor ou pior do que a PCA. Neste exemplo, os resultados foram semelhantes, mas o SOM pode ser uma opção interessante para testes adicionais, especialmente em casos em que a PCA não seja suficientemente informativa. HCA Utilizamos, neste exemplo um conjunto de dados composto por 20 variedades de soja (Glycine max (L.) Merrill), desenvolvidas pela EMBRAPA-Soja e recomendadas para o plantio na região Centro-Sul do Brasil. As 20 amostras de soja foram simultaneamente cultivadas em Londrina e Ponta Grossa, totalizando 40 amostras que foram quantificadas quanto à composição inorgânica (K, P, Ca, Mg, S, Zn, Mn, Fe, Cu e B) por ICP-OES (do inglês, inductively coupled plasma optical emission spectroscopy). Mais detalhes podem ser obtidos em Cremasco et al.53 Durante o experimento, as plantas foram submetidas às mesmas condições de fertilização e tratamento de irrigação, embora as duas cidades tenham características distintas de clima, terreno e temperaturas. Utilizando a diversidade do conjunto de dados, verificaremos a capacidade de agrupamentos das amostras usando HCA com base no perfil mineral, considerando a localização geográfica do cultivo. Esse conjunto de dados consiste em 40 amostras, igualmente distribuídas entre Londrina e Ponta Grossa, com 10 elementos determinados, resultando em uma matriz X de dimensões 40 × 10, disponível em "dados_soja" e YouTube.55 Ao carregar o material de demonstração, os usuários têm acesso à matriz "dados", que consiste nos valores obtidos para os 10 elementos quantificados em cada amostra. Além disso, há um vetor que contém as cidades de plantio de cada amostra, denominado "cidades", e um vetor com os símbolos dos elementos químicos determinados, chamado "var". A próxima etapa envolve a definição dos inputs da HCA na interface "HCA" disponível na janela "Análise Exploratória" do GAMMA-GUI. Nesta nova interface, os usuários devem inserir o nome da matriz "dados" na caixa "Matriz X (amostras × variáveis)" e o vetor contendo os nomes das amostras, denominado "cidades", na caixa "Célula com o nome das amostras (opcional)", conforme mostrado na Figura 6a.

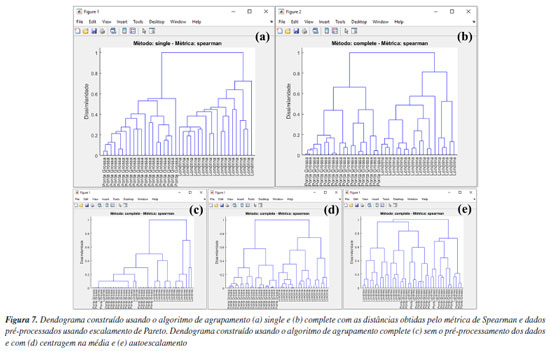

Por ser bem estabelecida há tempos, existe uma série de algoritmos disponíveis para a HCA.3 Portanto, uma forma de estimar a semelhança entre amostras é através do cálculo da distância entre elas. Usando a caixa "Métrica de distância", os usuários têm à disposição uma série de alternativas para estimar as distâncias entre pares de amostras (Figura 6b). Não existe uma regra geral para a escolha da distância que deve ser utilizada na HCA, e cada opção deve ser avaliada individualmente. Portanto, cabe aos usuários avaliarem separadamente as características de seus dados e tomar decisões sobre a métrica de distância que melhor se adequa aos objetivos da análise. Entre todas as possibilidades de métricas, a distância "euclidiana", "cityblock" (Manhattan) e "mahalanobis" são as mais populares entre os químicos. Para mais detalhes, consultar Ferreira.3 Entretanto, neste exemplo, após testar diferentes métricas, chegamos à conclusão de que a opção "spearman" produziu resultados mais adequados. Apesar de ser pouco comum, o coeficiente de correlação de Spearman (ρ) pode ser utilizado como métrica de distância na HCA.1 O coeficiente de correlação de Spearman (ρ) pode ser transformado em uma medida de dissimilaridade (distância) definida como: DSpearman(x, y) = 1 - ρ(x, y), onde DSpearman é a medida de dissimilaridade usada na HCA. Após definir a métrica para a estimativa das distâncias entre os pares de amostras, é hora de definir o método de agrupamento das amostras usando uma das opções na caixa "Método de agrupamento". No GAMMA-GUI, há uma série de alternativas de agrupamento disponíveis (Figura 6c), sendo os mais frequentes para os químicos o algoritmo do vizinho mais próximo "single", mais distante "complete", pela média "median", centroide "centroid" e de Ward "ward".3 A escolha do algoritmo de agrupamento depende da estrutura do conjunto de dados. Se os grupos estão bem discriminados, qualquer opção pode ser utilizada. Entretanto, se há uma sobreposição entre ou grupos ou alta proximidade entre eles, é preferível que usuários comparem os resultados entre os algoritmos do vizinho mais próximo (single) e mais distante (complete). Se os resultados forem iguais, isso sugere que as amostras estão naturalmente organizadas em grupos distintos.3 Neste caso, a comparação dos resultados entre os algoritmo single e complete, expressos nas Figuras 7a e 7b, revela que as amostras estão naturalmente organizadas em dois conjuntos distintos, uma vez que as amostras de Londrina e Ponta Grossa podem ser facilmente distinguíveis em ambos os casos, de acordo com um índice de dissimilaridade próximo a 0,8 (salto considerável na distância em relação à etapa anterior). Caso esse comportamento não fosse evidenciado, outra opção de análise de dados, como a PCA deve ser considerada.3 Nos dendrogramas da Figura 7, os índices de dissimilaridade (eixo das ordenadas) estão expressos em distâncias normalizadas. Para isso, basta os usuários marcarem a caixa "Normalizar as distâncias".

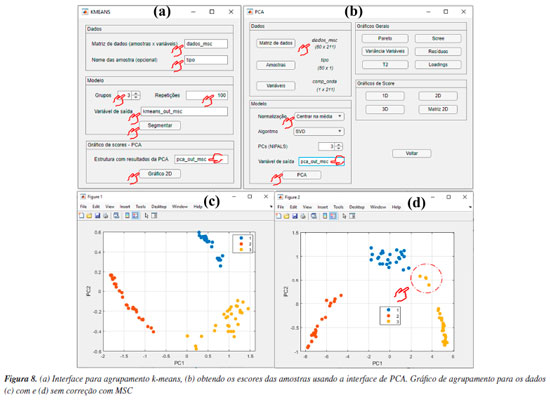

Por ser versátil, com várias possibilidades de combinações entre estimativas de métricas de distâncias e algoritmos de agrupamento, uma maneira eficaz de avaliar os resultados da HCA é através dos dendrogramas. Na Figura 7, temos os dendrogramas, uma representação gráfica na forma de um diagrama de árvore que exibe os agrupamentos (clustering) formados em cada passo e em seus níveis de similaridade. Cada nó no dendrograma representa um cluster ou um ponto de dados individual, e os ramos conectam os nós de acordo com a proximidade dos elementos, sendo que o tamanho dos ramos fornece o grau de dissimilaridade entre os grupos.54 Outro fator que deve ser considerado na análise dos dados é a aplicação do pré-processamento, conforme abordado na seção PCA. Na opção "Pré-processamento", os usuários podem testar diferentes possibilidades de pré-processamentos (Figura 6d). Neste caso, a comparação dos resultados entre os pré-processamentos de dados pode ser visualizada nas Figuras 7b-7e. Fica evidente nestes gráficos a importância da escolha do pré-processamento adequado, de modo que os resultados de agrupamento foram equivalentes usando Pareto (Figura 7b) ou centragem na média (Figura 7d), enquanto a ausência de pré-processamento (Figura 7c) ou a aplicação de autoescalamento (Figura 7e) pioraram os desempenhos, visto que amostras de Londrina foram agrupadas no grupo de Ponta Grossa e vice-versa. k-Means Nesta demonstração, vamos agrupar amostras de leites comerciais de acordo com o teor de gordura, utilizando dados espectrais adquiridos em um espectrômetro NIR portátil. Utilizaremos uma fração do conjunto de dados relatado no trabalho de Galvan et al.,56 que consiste em 80 amostras de leite, das quais 28 são amostras de leite integral (LI), 23 de leite desnatado (LD) e 29 de leite semidesnatado (LSD). A matriz X é composta por I linhas, que compreendem às amostras de leites, e J colunas, que correspondem aos comprimentos de onda em nanômetros, gerando uma matriz de dimensões 80 × 228, disponível no material de demonstração "dados_leite" e no YouTube.57 Desta vez, iniciaremos nossa demonstração utilizando a interface "Visualização e pré-tratamentos" (Figura 1Sa) para plotar o gráfico dos espectros e realizar o pré-tratamento dos dados. Nesta interface, aperte o botão "Plotar dados" e siga as instruções de preenchimento mostrados na Figura 5Sa (Material Suplementar). Durante a plotagem dos dados, os usuários têm a flexibilidade de criar suas próprias opções de rotulagem dos dados, entre outras opções, como excluir amostras do gráfico ou plotar classes específicas. Na Figura 5Sb, temos o gráfico dos espectros brutos das amostras. A análise visual dos espectros fornece informações importantes sobre como prosseguir no pré-processamento dos dados. Neste caso, é notável um deslocamento na linha de base nas ordenadas do espectro, possivelmente causado por efeitos de espalhamento aditivo e multiplicativo na absorbância, fenômenos característicos em espectros NIR. Observa-se ainda que, a partir de 1650 nm, ocorre um comportamento atípico no espectro, com aumento do ruído que se sobrepõe aos sinais dos espectros, e um ruído discreto entre 1400 e 1500 nm. Esses ruídos, resultantes da menor sensibilidade do detector ou da baixa intensidade da radiação em comprimentos de onda mais elevados, podem comprometer a análise dos dados. Em espectroscopia NIR, os pré-processamentos mais frequentemente aplicados incluem o uso de derivadas para a correção de efeitos aditivos, além de algoritmos como MSC ou SNV para corrigir efeitos multiplicativos e aditivos na absorbância. Além disso, algoritmos de alisamento, como a média móvel ou o filtro de Savitzky-Golay, são comumente empregados para reduzir o ruído nos espectros. É recomendável que os usuários testem diferentes opções de pré-processamento disponíveis no aplicativo. Para mais detalhes sobre os pré-processamentos, os leitores podem consultar Ferreira.3 Neste exemplo, após alguns testes, verificamos que cortar os espectros entre 900 e 1650 nm e aplicar o MSC foi suficiente para o agrupamento eficiente das amostras. Embora fosse possível aplicar também a primeira derivada com alisamento de Savitzky-Golay para corrigir efeitos de linha de base e ruído, os resultados obtidos foram similares, e por isso optamos por não incluir essa etapa extra. Para cortar os espectros, os usuários devem clicar no botão "Selecionar variáveis" e, em seguida, definir a matriz de dados (correspondente aos espectros brutos), o vetor de intensidades (relacionado aos comprimentos de onda) e, por fim, especificar a faixa desejada no campo apropriado, conforme indicado no aplicativo. Após cortar os espectros, a estrutura "sel_out" aparecerá no workspace do Matlab. Acessando essa estrutura, o usuário encontrará a matriz X com os espectros cortados, chamada "dados", e um vetor "faixa", que representa os comprimentos de onda dos espectros entre 900 e 1650 nm. Esses dados podem ser extraídos da estrutura (opcional). Para isso, basta clicar na matriz "dados", acessar a aba superior "VARIABLE" do software e, em seguida, clicar no botão "New from Selection" (ícone "+" amarelo no canto superior esquerdo), repetindo o mesmo procedimento para o vetor "faixa". Optamos por renomear a matriz "dados" para "dados_brutos" e o vetor "faixa" para "comp_onda", substituindo-os pelos dados cortados. Caso o usuário prefira não substituir os originais, basta atribuir novos nomes às variáveis. Ou, na linha de comando da "Command Window" (>>), o usuário pode escrever dados_brutos = sel_out.dados e comp_onda = sel_out.faixa. Em seguida, aplicaremos o algoritmo MSC na matriz de dados X cotada, ou seja, contendo a faixa espectral entre 900 e 1650 nm. Para isso, basta apertar o botão "Correção de sinal" e seguir as instruções de preenchimento da Figura 5Sc. Comparando os espectros das Figuras 5Sb e 5Sd, observa-se a correção do deslocamento na linha de base e a exclusão da região após 1650 nm. Após aplicar a correção com MSC, a estrutura "xcor_out" aparecerá no workspace do Matlab. Acessando essa estrutura, o usuário encontrará a matriz X com os espectros corrigidos, chamada "dados", que pode ser extraída da estrutura (opcional). Para isso, basta clicar na matriz "dados" e seguir o procedimento descrito anteriormente, renomeando-a para "dados_msc". Alternativamente, o usuário pode usar a linha de comando da "Command Window" digitando: dados_msc = xcor_out.dados. A próxima etapa envolve o uso do k-means na interface "Análise Exploratória". Nesta interface, aperte o botão "KMEANS" e inicie definindo os inputs nas caixas disponíveis da nova janela que se abrirá, inserindo o nome da matriz de dados "dados_msc" na caixa "Matriz de dados (amostras × variáveis)" e o nome das amostras "tipo" na caixa "Nomes das amostras (opcional)", conforme ilustrado na Figura 8a. O número de grupos deve ser ajustado para três usando o botão "Grupos", pois, neste caso, temos três tipos de leite (integral, semidesnatado e desnatado). Essa etapa não torna o k-means um algoritmo de aprendizado supervisionado, pois não depende de dados de entrada rotulados para treinamento.1 Caso não se saiba a quantidade de grupos, é possível fazer o modelo com diferentes quantidades de grupos e comparar qual produz uma segmentação mais adequada. Por fim, o número de repetições que os dados serão avaliados deve ser definido na caixa "Repetições", sendo cem repetições o default do aplicativo. O k-means é um algoritmo que inicia a localização do centro dos grupos aleatoriamente, portanto, a cada vez que é executado, o resultado pode ser ligeiramente diferente. Assim, como resultado, cada amostra será atribuída à classe na qual foi classificada na maioria das vezes, considerando todas as repetições realizadas.

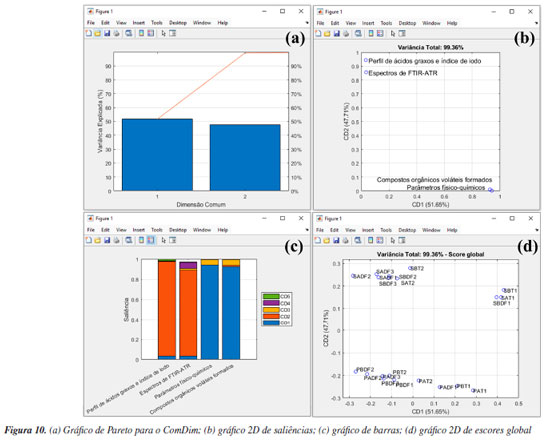

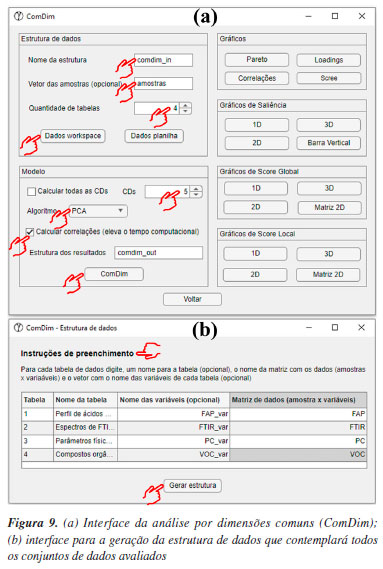

Antes da segmentação dos dados na caixa "Variável de saída", optamos por redefinir o nome da estrutura de saída dos resultados para "kmeans_out_msc", pois, adiante, iremos comparar os resultados com e sem a correção MSC. Essa comparação tem apenas o objetivo demonstrativo, para destacar a importância da etapa de pré-processamento antes da análise dos dados. É importante deixar claro aos leitores que não é adequado realizar a análise dos dados sem a execução prévia das etapas de pré-tratamento. Após essas etapas, apertar o botão "Segmentar" e, em poucos segundos, a análise será finalizada, gerando a estrutura "kmeans_out_msc" no workspace do Matlab. Na estrutura recém-criada, os usuários têm acesso aos resultados de agrupamento das amostras em "grupos", entre outros resultados da análise. Na estrutura "grupos", há três subestruturas que correspondem aos três grupos previamente estabelecidos. Ao acessar cada uma das subestruturas, os usuários podem verificar quais tipos de amostras foram agrupadas neste respectivo grupo. Neste caso, é possível observar que cada grupo contém somente amostras LSD, LD e LI. Uma opção gráfica dos resultados do k-means é a "projeção" dos agrupamentos nos escores das amostras obtidos com PCA. Para isso, é necessário realizar uma PCA para o mesmo conjunto de dados, conforme ilustrado na Figura 8b. Após a realização da PCA, retorne para a interface do k-means e, na caixa "Estrutura com resultados da PCA", o usuário precisa digitar o nome da estrutura de saída da PCA, neste caso "pca_out_msc", e então apertar o botão "Gráfico 2D". Na opção de gráfico 2D, o usuário pode escolher quais PCs deseja plotar, sendo que, neste caso, escolhemos a PC1 vs. PC2, ver Figura 8c. Para fins comparativos, realizamos o mesmo procedimento descrito anteriormente, mas desta vez, utilizando o conjunto de dados sem correção com MSC "dados_brutos", e obtivemos a Figura 8d. Ao projetar os resultados do agrupamento k-means nos escores da PC1 vs. PC2 gerados pela PCA, é notável a importância do pré-processamento aplicado, neste caso, a correção por MSC (Figuras 8c e 8d). Com a correção MSC, os leites semidesnatado (azul), desnatado (vermelho) e integral (amarelo) formam três agrupamentos distintos e bem definidos. Em contraste, ao utilizar os dados sem a correção MSC (Figura 8d), quatro amostras de leite semidesnatado (marcadas em amarelo no gráfico) foram erroneamente agrupadas no cluster das amostras de leite integral (azul). ComDim Nesta demonstração, exploraremos a estabilidade oxidativa da oleína de palma refinada e do óleo de soja parcialmente hidrogenado, submetidos ao processo de fritura industrial de produtos cárneos de frango usando a análise multibloco/multitabela.58 O conjunto de dados fornecido, denominado "dados_oleos", abrange quatro matrizes distintas, conforme vídeo no YouTube.59 A primeira matriz, compreende o perfil de ácidos graxos e índice de iodo, determinados por GC-FID (do inglês, gas chromatography-flame ionization detector), em 20 amostras de óleos, gerando uma matriz de dimensões 20 × 18, denominada "FAP". A segunda matriz, é composta pelos dados de fingerprint obtidos por FTIR-ATR (do inglês, Fourier transform infrared spectroscopy-attenuated total reflectance), gerando uma matriz de dimensões 20 × 2479, denominada "FTIR". A terceira matriz engloba a determinação de 6 parâmetros físico-químicos, resultando em uma matriz de dimensões 20 × 6, denominada "PC". Por fim, a quarta matriz incorpora dados da determinação de compostos orgânicos voláteis formados, analisados por SPME (do inglês, solid phase microextraction) e GC-FID, resultando em uma matriz 20 × 8, denominada "VOC". No vetor "amostras", os usuários têm acesso à identificação das amostras. As amostras iniciadas com a letra "P" representam a oleína de palma, enquanto as iniciadas em "S" correspondem ao óleo de soja. A segunda letra identifica os dois produtos cárneos de frango, sendo "A" e "B" submetidos à fritura. Além disso, as letras "T1" e "T2" representam o tanque de armazenamento antes e após a fritura, respectivamente. Já as amostras identificadas como "DF1", "DF2" e "DF3" referem-se ao tanque da fritadeira após 1, 2 e 3 h do processo de fritura. Mais detalhes podem ser encontrados em Silva et al.58 O ComDim é uma análise multibloco exploratória de dados, desenvolvido para extrair informações comuns de dados gerados a partir de diferentes fontes, ou seja, conjuntos de dados diferentes adquiridos para as mesmas amostras. Nesse sentido, o emprego do ComDim fundamenta-se na condição de que as matrizes de dados tenham apenas o mesmo número de linhas, não sendo obrigatório que tenham o mesmo número de colunas. Além disso, é fundamental observar que as amostras devem estar dispostas na mesma ordem em todas as matrizes de dados avaliadas.33,34,38 A principal vantagem do ComDim, comparada à PCA, reside na sua capacidade de realizar a extração de características relevantes de cada fonte de dados simultaneamente em uma única etapa, graças à sua natureza multibloco. Isso elimina a necessidade de conduzir diversas análises PCA separadas, simplificando e melhorando consideravelmente a interpretação dos dados. Além disso, a análise das saliências permite avaliar se os dados de diferentes fontes apresentam informações comuns ou complementares, e qual o peso de cada tabela nas dimensões comuns geradas. Na janela "Análise Exploratória" do GAMMA-GUI, os usuários precisam apertar o botão "ComDim", e uma janela semelhante a Figura 9a se abrirá. Uma etapa fundamental que antecede a análise dos dados consiste na geração da estrutura que contém cada conjunto de dados, que tem como default a nomenclatura "comdim_in". Iniciamos a construção da estrutura definindo alguns inputs fundamentais, como a definição opcional do vetor que contém o nome das amostras, digitando "amostras" na caixa "Vetor das amostras (opcional)". Na etapa seguinte, o usuário precisa ajustar, usando o botão "Quantidade de tabelas", o número de tabelas avaliadas, neste caso, são quatro tabelas. Então, deve apertar o botão "Dados workspace". Após isso, uma nova janela semelhante à Figura 9b se abrirá. Neste exemplo, utilizamos dados que já estavam no workspace previamente carregados. No entanto, se o conjunto de dados utilizado estiver em uma planilha do Excel, os usuários podem ainda usar o botão "Ler planilha" para gerar a estrutura de dados.